Google Cloud Datalb で kaggle の画像コンペ用の画像データを扱えるようにする。 2018/09/28

かえるるる(@kaeru_nantoka)です。

今回は、有料のGPUインスタンスが立てられる、 Google Cloud Datalab 環境で

kaggle の画像コンペ用の大容量の画像ファイルを扱えるようにするプロセスについて書いていきます。

以前、無料でGPU を扱える Google Colab で似たようなエントリを書いたのですが、Datalab の GPUインスタンスでは幾分勝手が違いました。ということで備忘として残していきます。

今回のゴール **

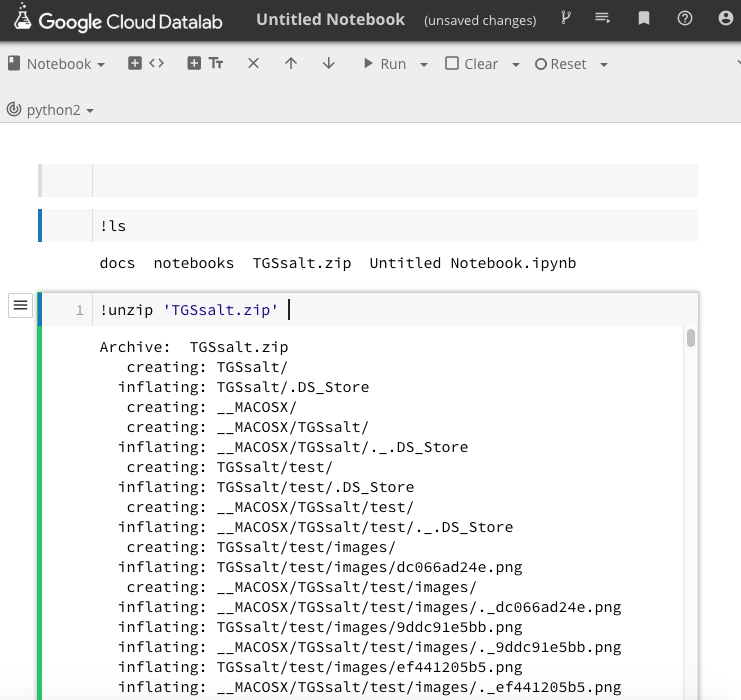

(写真A)

からの

img = load_img("TGSsalt/train/hoge/fugafuga12345.png")

や

train_df = pd.read_csv("TGSsalt/train.csv")

で、エラーにならず読み込めるようになることです。

********

1 )

写真A の上部真ん中あたりに、 upload と書かれたところがあります。

ここを押すと ファイルをアップロードできます。

kaggle の画像ファイルは大容量なので、「容量が大きいですよ!」という旨のポップアップが出ますが、それほど時間もかからずアップロードできます。

2 )

今回のポイントです。

最初私は、デフォルトで存在するディレクトリの datalab/notebook/ というところに 新規notebook を立ち上げ、意気揚々と以下のコマンドを叩きました。

../datalab/TGSsalt.zip #画像がたくさん入っているディレクトリを固めた zipファイル

すると「そのようなファイル、ディレクトリはないですよ〜」と言われました。

はい、 パスが通っていないのです。

Google Colab では、drive/My \ Drive というところにマウントされるので、

drive/My \ Drive/hoge/fuga でパスを通すことができました。

ということで根本的な解決策ではないですが、同一ディレクトリ上に notebook を立ち上げて、ことなきを得ました。

3 )

(写真B)

写真の通りです。

こちらは Colab に比べると光の速さで(気持ちの問題です笑)展開されました。

まとめ **

実際に画像がうまく読み出せている画面キャプチャはあるのですが、コンペ期間中なので控えておきます。

私と同じ事象ではまったどなたかの一助になれば幸いです。

以上、ありがとうございました。

Happy Kaggling !